SIGGRAPH2007まで残すところ一カ月。コース・論文・テクニカルスケッチ共に、ほぼそのスケジュールが発表された。

今年の開催地は西海岸のサンディエゴ。一般的に、西海岸で開催されるSIGGRAPHはプロダクション色の強いものになるといわれているが、今年のSIGGRAPHにもそのような傾向が見られそうだ。(倉地紀子)

|

|

■映画制作に関する理論・技術が多数登場

|

2000年以降、CG理論やCG技術の研究開発は、「リアルタイム」「インタラクティブ」の世界へと移っていった。当然のことながら、ここでは、将来性のある実用化のターゲットとして、ゲームなどのインタラクティブエンタテイメントが筆頭に挙がっていた。だが、意外にも今年は、映画制作での実用化を目指した理論や技術が数多く出てきている。プロダクションと大学などの研究機関が共著で発表する論文も多い。

このような傾向は、一つには、映画制作においてCGが果すべき役割に変化がでてきたことに起因している。これまでの映画制作では、CGはあくまで「ポストプロダクション」という役割、つまり撮影がすべて終了したのちに、撮影画像を加工するという役割に留まっていた。そして、そこでは、「リアルタイム」という要素はほとんど必要とされなかった。

だが、CGがより一般的になるにつれて、CGの関わる作業がポストプロダクションだけに収まりきらなくなってきた。たとえば、CGキャラクターの登場する実写映画や、実写出身の監督が制作する3DCG映画では、監督がセットを用いて演技付けする際に、それをモニター上のCG空間でリアルタイムに確認しながら、作業を進めることが求められるようになってきている。

ここにきて「リアルタイムCG」という要素が、映画制作とも決して無縁ではなくなってきたのだ。また、一方では、制作現場での「リアルタイム」への要請も高まっている。ここでも、CGがCGであることを、アーティストがより意識せずに作業がおこなえることが求められるようになってきたのだ。

CGツールがいかに進化したとはいえ、ペンで紙に描く場合と違って、いまだにCGの場合には、描いたものを見るまでに僅かながらも待たなくてはならない。仮にもこの「待つ」時間がゼロになったとしたら、やはりアーティストのクリエイティビティは大きく向上するだろうといわれている。映画制作での実用化を目指した奥の深い理論や技術が登場するようになった背景には、もちろん時代と共に移り変わるトレンドというものもあるのだろうが、上記のような現場からの要請も色濃く反映されているといえる。

|

|

■GPUレンダリングシステム Lightspeed

|

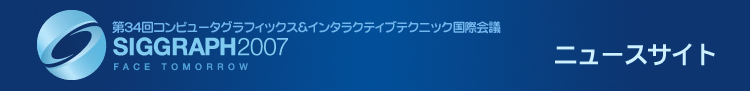

写真1

画像左は、透過とモーションブラーを加えてLightSpeedでレンダリングしたもの。

画像右は、同じシーンを同じライティングのもとでレンダーマンによってレンダリングしたもの。両画像の誤差は0.1%に満たない。

「The Lightspeed Automatic Interactive Lighting Preview System」(Proceedigs of Siggraph2007, Jonathan Ragan-Kelley, Charlie Kilpatrick, Brian W. Smith, Doug Epps, Paul Green, Christophe Hery, Fr?do Durand)より

|

映画制作に関連した技法の中でも、今年はハードやデバイスに関連したものが多い。映画制作で用いることのできるデバイスは、それこそ宇宙開発で用いるような特別に高価なものであってはならない。できるだけシンプルで低価格なデバイスを用いて、いかに映像制作に有意義なデータをつくりだすかが鍵となる。

GPUやComputational Photographyの理論をうまく単純化して導入するという傾向が強く見られる。その最も典型的な例が、LightspeedというGPUレンダリングシステムだ。光の分布が複雑なシーンのライティングをおこなう場合、レンダリングの結果をリアルタイムにプレビューしながらライティングをおこなうことができれば、非常に効率がよくなる。Lightspeedは、このようなプレビューを意図したシステムで、ライティングをおこなうアーティストのためのシステムといえる。

このシステムでは、特殊なチップを開発して用いるということはおこなっていない。ごく普通のGPUを用いて、レンダーマンでレンダリングしたもののライティングを、変化に応じてインタラクティブに再レンダリングする。同じようなコンセプトの手法はこれまでにも存在したが、このシステムではシェーダーの自由度も高く、スピードもかなり上がっているようだ。

特に、透過、モーションブラー、アンチエリアス、サブサーフェススキャタリングといった、映画制作において非常に有意義な機能が、はじめて可能になったことの意義は大きい。システムの中核を設計したのはMITだが、サブサーフェススキャタリングなどのシェーダー部分はILMが共同開発している。

まだ正式には発表されていないが、ILMが新たに開発中のサブサーフェーススキャンタリングのシェーダーも、すでにLightspeedで実装されつつある。シェーダー部分を担当したクリストフ・へリー氏によると、Lightspeedは「バイレーツ・オブ・カリビアン3」や「トランスフォーマー」などのプロジェクトでも部分的に用いられており、近い将来、ILMでは全社的にこのシステムが導入されることになるそうだ。(写真1)

|

|

■MERLが新たな光学式モーションキャプチャーシステム

|

写真2、3

モーションキャプチャの際に、人体に貼り付けるタグ。左が装着したイメージ、右はタグの内部。タグには、空間上の位置、回転角度(物体表面の向き)、環境全体から差し込む光の色と強さのそれぞれを記録する3種類のセンサーが付いている。計測では、タグは衣服の内部に取り付けることができ、計測する環境への制限も少ない。

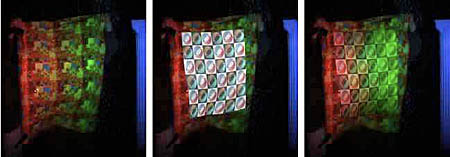

写真4

左:12個のタグを付けて布を計測。

真ん中:計測されたそれぞれのタグの位置と回転角度をもとにして、布にテクスチャを

あてがってもの

右:計測によって得られた、それぞれのタグの位置に環境全体から差し込む光の色と強さをもとにして、テクスチャに色付けをおこなったもの。

写真2、3、4:「Prakash: Lighting Aware Motion Capture using Photosensing Markers and Multiplexed Illuminators」(Proceedigs of Siggraph2007, Ramesh Raskar , Hideaki Nii, Bert deDecker, et al.)より

|

映画制作におけるCG技術と切り離すことのできないデバイスとして、モーションキャプチャが挙げられる。前述したように、近年では、監督が役者に付けた演技を、モニター上でCGキャラクターの演技としてリアルタイムに確認しながら、演出を進めていくことが求められるようになってきた。

そのような要望に答えるためにも、リーゾナブルな価格で、高速になおかつ高い自由度で、データーを取り込めるデバイスが必要となってくる。上記のようなコンセプトを備えたデバイスとして、MERL(Mitsubishi Electric Research Laboratories. Inc.=三菱電機の北米における研究開発拠点。コンピュータアプリケーションと通信映像の分野で基礎研究および先進技術の研究開発をしている)から発表されたのが、Prakashという光学式のモーションキャプチャシステムだ。

一般的に、光学式のモーションキャプチャは、高速度カメラを必要とするため、そのコストが高くなる。Prakashでは、カメラそのものは通常のカメラを用い、白黒のコードフィルムで覆ったプロジェクターを通して光を当てる。コードフィルムが黒の部分は光を通さないが、白の部分は光を通す。そして、センサーのついたタグは、光を感知したかしなかったかを信号として記録する。

プロジェクターは、複数のライトとこれに対応した複数の異なったコードで構成されており、時間軸に沿ってライトを切り替える。センサーが記録する信号は、センサーがついているタグと各ライトとの位置関係によって変わってくる。この変化を吟味することによって、タグの空間上での位置を復元することができるのだ。(写真2、3)

システムを考案したのは、昨年に続いて今年もComputational Photographyのコースをオーガナイズするラメッシュ・ラスカー氏。「高価な機材の代わりに頭を使った手法」なのだという。「頭を使う」過程で、オプティクスやコンピュータビジョンの分野で培われてきた理論的な裏付けがうまく導入されている点が、この手法の特徴となっている。タグには、位置を記録するセンサーだけでなく、回転を記録するセンサーや環境から差し込む光の総量を記録するセンサーも着いている。そして、これらの情報を総合して、タグの周りの物体の反射特性も復元できる。このため、動きを取り込んだCGの物体を実写と合成するような作業が必要とされる場合には、非常に有効だといえる。

ラスカー氏の出身はインド。Prakashとは、サンスクリッド語で「光」を意味しているのだそうだ。低価格で自由度の高いモーションキャプチャの技法は、Prakashの他にも複数の論文で発表されており、いずれも、特殊な空間での制限の大きい計測ではなく、屋外などのシーンでも正確な計測がおこなえることを目標としたものとなっている。(写真4)

|

|

■映画「300」でも使用されたバーチャルリフォーカス

|

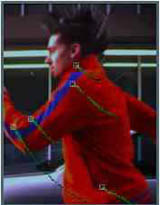

写真5

レンズとカメラ本体との間に、白と黒のチェック状のコードで覆ったフィルムを挿入して撮影をおこなう。これによって、露出時間内にレンズの口径を変化させながら撮影をおこなうことができる。

写真6

入力画像。人間も背景も共に焦点が合っていない。

写真7

出力画像。上記の撮影方法によって得られた画像の集合を用いて、仮想的にリフォーカスをおこなったもの。人間だけに焦点を合わせた画像が生成されている。

|

ラスカー氏は、上記の手法の他に、コードを用いて露出時間内で口径を変化させながら撮影をおこなうことによって、撮影時とは違った任意の焦点距離で撮影した画像を生成する手法(バーチャルリフォーカス)も発表している(写真5、6、7)。

バーチャルリフォーカスは、今年のComputational Photographyの分野の論文がこぞって取り上げているテーマでもあり、この方向性の研究に対する興味の高さを示している。

これらの研究は、決して映画制作での実用化に的を絞ったものとはいえないが、バーチャルリフォーカスの技法はすでに映画「300」でも使用されており、今後映画VFXでもその活用の可能性が大きいといえる。

もともと、コンピュータビジョンの分野で産声をあげたイメージベースドの手法が、今日の映画制作のパイプラインを大きく変えたように、コンピュータビジョンでの研究をバックグラウンドにしたComputational Photographyの研究成果が映画制作の流れを変える日も、そう遠くはないのかもしれない。

|

|

▲ページトップに戻る

|

|

|