デバイス①"Shield Field"

デバイス②"BiDi Screen"

人間のビジュアル・アビリティを無限に高めるために

デバイス③"Transient Imaging Camera"

"社会的インパクト"のあるカメラを作り出すために

デバイス④"Bokode"

デバイス⑤"NETRA"

前編で紹介したように、今日に至るまでのRaskar氏の研究の歩みは、博士論文のテーマでもあったプロジェクタを用いた画像生成に源を発していた。Raskar氏が目指していたのは、プロジェクタの設定に様々な工夫を凝らすことによって、光と物体の干渉を高い自由度で復元できるようにすることだった。Raskar氏はこれを “プロジェクタを用いたイルミネーションの研究”とよんでいる。そして、ここで培ったアイディア(特にコード・マスクを用いるアイディア)をカメラ内部にもち込むことによって、Coded Computational Photographyという独自の研究カテゴリを作り出していった。もっとも、Raskar氏がComputational Photographyというテーマに打ち込んでいったのには、MERL(Mitsubishi Electronic Research Laboratory)の研究員だからという理由もあったようで、決してイルミネーションの研究に対する同氏の情熱が失せたわけではなかった。実際のところ、2007年に発表したプロジェクタを活用したモーションキャプチャ・デバイスのPrakashでは、物体の動きのみならず、物体の反射特性の復元も目指されていた。その後、MITに移り自らの研究室を開設してからは、晴れて Computational Photographyとイルミネーションとを融合させた研究の方向性を打ち出していくことになった。

前編で紹介したように、Raskar氏が提唱したCoded Computational Photographyの2本の軸は、コード・マスクの活用と、ライトフィールドの考え方だといえる。Computational Photographyとイルミネーションとの融合の第一歩は、この2つの軸に対して、さらにライティングというコンセプトを加えることから始められた。その代表例が、SIGGRAPH ASIA2008で発表された“Shield Field”と、SIGGRAPH ASIA2009で発表された“BiDi Screen”とよばれるデバイスだといえる。

コンピュータ・ビジョンの分野では、撮影画像から物体の3D形状を復元するための、実に様々な方法論が考案されてきた。その1つとして、物体に様々な方向から光を当て、その影を解析することによって、物体の大雑把な3D形状を復元するという方法がある。この方法の場合、光源の位置を様々に変化させて数多くの画像を撮影する必要がある。しかし、Raskar氏らのチームがSIGGRAPH ASIA2008で発表した“Shield Field”という手法を用いると、たった1度の撮影で得られた画像を用いて、高速に3D形状を復元することができる。

“Shield Field”のコンセプトは、ライトフィールドの場合とほぼ同様である。その要素は、ライトフィールドを構成する各レイ(光線)が物体に遮られることによってどれだけ減衰するかを表す関数となっている。したがって、“Shield Field”を構築するためには、まずライトフィールド・カメラの内部構造と同様のデバイス設定を行う。ここではLEDで物体を照らし、コード・マスクの配列で覆われたディフューザに写った影を、その後方からカメラで撮影する。LEDが発する光は、ライトフィールド・カメラの場合の(メインレンズを通して入り込む)外界からの光に相当する。ディフューザに写った物体の影をその後方からカメラで撮影するというしくみは、ライトフィールド・カメラの場合のセンサに相当する。物体が存在する場合と存在しない場合とで“Shield Field”がどのように変化するか(=ライトフィールドを構成する各レイの強さがどのように変化するか)を吟味することによって、物体の形状を復元することができる。ライトフィールド・カメラの場合と同様に、ここで用いられているコード・マスクの配列も、ピンホール(pinhole)の配列を置き代えたものとなっている。コード・マスクはピンホールに比べてより多くの光を通すことができるため、計測処理をほぼリアルタイムに近い速度まで効率化することができる。

前編で紹介したようにRaskar氏らは、2007年のSIGGRAPHで発表したDappled Photographyにて、コード・マスクをライトフィールド・カメラに導入した。“Shield Field”では、理論的な見地から最も理想的なコード(MURAコード)を見出すことに成功した。このコードは、Raskar氏らのその後のプロジェクトに受継がれていくことになった。

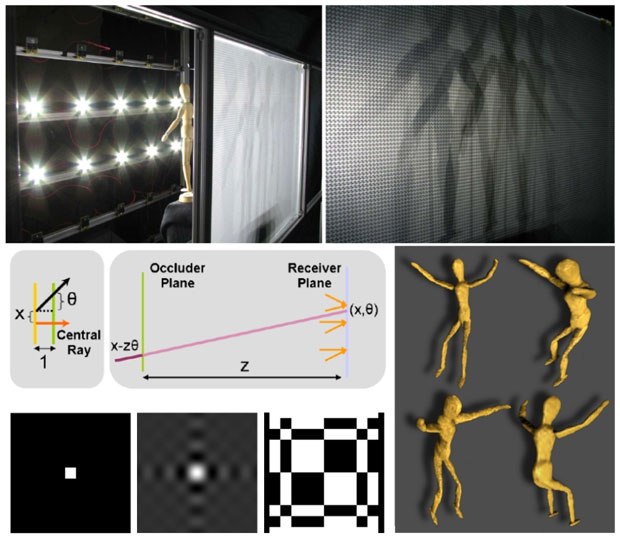

"Shield Field"

"Shield Fields: Modeling and Capturing 3D Occluders"

(Douglas Lanman, Ramesh Raskar, Amit Agrawal, Gabriel Taubin, SIGRRAPH ASIA2008)

(Image Courtesy: Douglas Lanman)

"Shield Field"では、LEDの配列を用いて物体を照らす。その影を、物体の背後のディフューザに投影し、ディフューザの背後に設置したカメラで撮影する(上段図)。ディフューザの前には、下段左図のようなピンホール、またはコード・マスクが格子状に並べられている。(3枚の画像の最右端がMURAコード)LEDを発し、このピンホールまたは、コード・マスクの配列を通してディフューザに到達したレイ(光線)の集合は、ライトフィールドを作り出す。ライトフィールドに伝わる光の強さが、物体に遮られたことで、どのように減衰したかを吟味することにより(中段左図)、物体の3D形状を復元することができる。(中段下段右図)

SIGGRAPH ASIA2009で発表された“BiDi Screen”とは、LCD(液晶ディスプレイ)とセンサを1組にしたデバイスである。ユーザはLCDから離れた状態で、LCDに映し出される仮想空間に対して、様々なインタラクションを行うことができる。デバイスの実体は非常に薄いLCDなのだが、通常のLCDを細かいコンポーネントに分解し、構築し直している。LCDの構成要素は、大きく分けてバックライトとライトモジュレータの2つであり、ディスプレイ・モードでは、通常のLCDと似通った働きをする。独自性が強いのはキャプチャ・モードで、このモードではバックライトはオフになり、ライトモジュレータには前述のMURAコードを格子状に並べたものが写し出される。外界からデバイス内に入った光は、このコード・マスクを通過し、LCDの後部に配置されたセンサ(またはディフューザに写った像をその後方のカメラで撮影するしくみ)によってキャプチャされる。デバイスの前でユーザが与えた情報(ユーザのジェスチャや、ユーザの操作によってフラッシュライトが発した光など)も、同様の経路でキャプチャされる。

ライトフィールド・カメラの場合と同様に、外界とセンサを結ぶレイの集合は、ライトフィールドを作り出す。キャプチャされた情報は、このライトフィールドを用いて解析され、3DCGの仮想空間内で組み合わされ、LCDを通してユーザにフィードバックされる。たとえばデバイスの前でユーザが“手”をかざすと、その情報はキャプチャされ、ライトフィールドを用いて解析される。そして、“手”を様々な視点から捉えた画像が生成される。これらの画像を用いると、3D空間における“手”のデプス情報を復元することができる。その結果、この“手”を3DCGの仮想空間内で自在に操作して様々な見え方を作り出し、ユーザにフィードバックすることができる。このような処理が非常に高速に行われるため、ユーザとデバイス上の仮想空間との間で、様々なインタラクションが可能となる。ここでもライトフィールドの復元は、理論的にはピンホールの配列でも可能なのだが、コード・マスクを用いることによって、キャプチャの性能を大幅に高めることができる。

2009年はCG分野での物理的なインタフェース研究に光が当てられた年といえ、“BiDi Screen”はこのような流れを汲んで、ライトフィールドの考え方を新たなインタフェース開発という領域にもち込んだ意欲的なプロジェクトだったといえる。

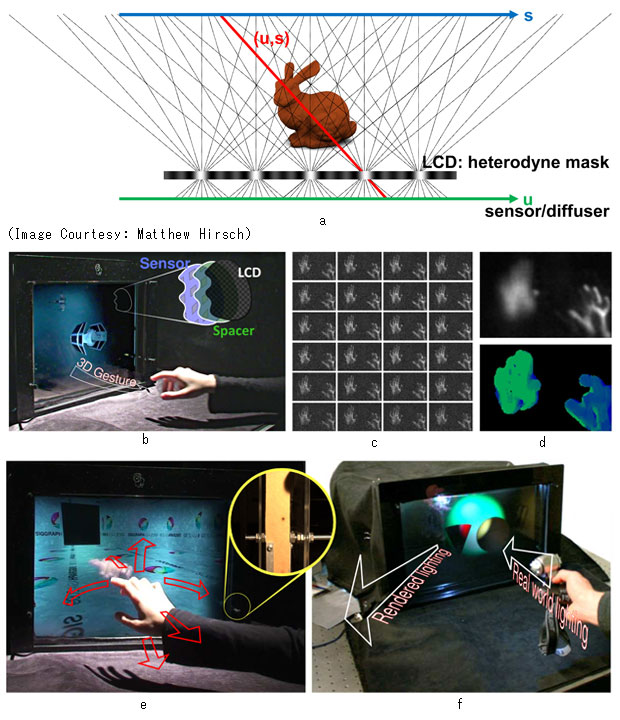

"BiDi Screen"

"BiDi Screen: A Thin, Depth-Sensing LCD for 3D Interaction using Light Fields"

(Matthew Hirsch, Douglas Lanman, Henry Holtzman, Ramesh Raskar, SIGGRAPH ASIA2009)

(C)ACM 2009

"BiDi Screen"はLCDとセンサを1組にしたデバイスで、ユーザがLCDから離れた状態で与えた情報をキャプチャし、3DCGの仮想空間内に復元し、LCDを通してフィードバックする。キャプチャ・モードでは、LCDのライトモジュレータにマスク・コードが写し出され、図aのように、外界(s平面)からマスク・コードを通してセンサ(u平面)に到達するレイの集合が、ライトフィールドを作り出す。

たとえばユーザがLCDの前で図bのようなジャスチャをとると、その情報がキャプチャされ、ライトフィールドを用いて解析される。すると図cのように、このジェスチャを様々な視点から捉えた画像が生成され、これらの画像を用いて、図dのようなジェスチャのデプス情報が復元される。(図dは、ジェスチャの任意の地点にフォーカスできることを示している)デプス情報を復元することによって、このジェスチャを通して図eのように3DCGの仮想空間を自在に操ることできるようになる。

図fのように、ユーザがフラッシュライトを用いて与えたライト情報を3DCGの仮想空間内で復元し、このライト情報を用いて仮想空間内の3DCGの物体をレンダリングし、フィードバックすることもできる。

インドのCollege of Engineering, Pune(Department of Electronics and Telecommunication)でロボット工学を学んだ後、博士号取得のためアメリカに渡り、University of North Carolina at Chapel Hillでコンピューター・ビジョンとコンピューター・グラフィックス(CG)を学ぶ。2000年にMERL(Mitsubishi Electronic Research Laboratory)に加わり、数々の名誉ある業績を残すと同時に、Computational Photographyという新たな研究分野の確立・発展に大きく貢献する。2008年にはMIT Media LabのAssociate Professorに就任。"Camera Culture Group"と名付けた研究室を開設し、Computational Photographyの未来を担う研究(Computational Light Transport)を続けている。名著と噂される著書"Computational Photography"(AK Peters)の発売も、この夏予定されている。研究や教育活動の詳細はこちらで紹介されている。